Dominigel Rodriguez Peña

Pontifica Universidad Católica Madre y Maestra, PUCMM

Introducción

Las peleas de gallos consisten en un combate entre dos gallos de un mismo género, las cuales se realizan dentro de una gallera o coliseo. (Pelea de Gallos) Las apuestas de gallos son una actividad popular en muchas partes del mundo. A pesar ser consideradas ilegales en ciertos países, en la República Dominicana las apuestas de gallos son una actividad legal y regulada por el gobierno. (Decreto N.º 250-99. Decreto que aprueba El Reglamento de la Comisión Nacional de Lidias de Gallos. 1999).

Mas allá de esto, las peleas de gallos en la República Dominicana son un evento tradicional, en donde se suelen atraer a muchos espectadores y a menudo se realizan apuestas sobre el resultado de la pelea. Aunque es una práctica arraigada culturalmente y considerada un deporte en el país, existe una falta de mecanismos que formalicen este deporte, estancando su expansión y posible internacionalización de juegos dominicanos, lo que, a la larga, podría favorecer a la economía dominicana.

Es crucial abordar estas deficiencias para mejorar la credibilidad de las apuestas, lo que impacta directamente a los participantes y a la sociedad en general al promover apuestas más justas y seguras.

Contexto

En las peleas de gallos se tiene una gran informalidad, en estas ha habido históricamente una falta de transparencia, confianza y seguridad para los participantes quedando esta última en base a la palabra de cada individuo como coloquialmente se llama “palabra de gallero”. Estos problemas se derivan de la ausencia de mecanismos que garanticen la equidad e integridad de las apuestas.

El sistema de apuestas de gallos en República Dominicana tiene distintas formas. Una de ellas consiste en tener un intermediario llamado “juez de malla”, el cual recibe todas las apuestas apostadas por ambas partes (en este caso, un jugador A y un jugador B) que deseen apostar en contrariedad para posteriormente entregarle los fondos al ganador y actuando como testigo de la promesa realizada.

El sistema tradicional genera 70 mil millones de pesos dominicanos anualmente entre todas las bancas de apuestas, esto sin contar lo generado por las galleras siendo parte importante de los 100 millones de pesos que se mueven diariamente en los juegos de azar en República Dominicana. (Diario, Bancas de Apuestas Tienen Ganancias de RD$70 mil mm Al Año 2015) (El Nacional, Juegos Azar rd mueven $100 Millones Diarios 2013)

Proyectos Relacionados

El mercado de los juegos de azar en internet y con la integración con criptomonedas ha permitido mover más de 50 billones solo en la plataforma de Stake.com, siendo un sitio de apuestas en línea. (Danckert, The secret australian origins of the world’s biggest crypto casino 2021).

En el artículo presentado en la conferencia International Conference on Blockchain Applications «Smart Contracts for Sports Betting: A Decentralized Approach» por M. Chen, S. Shen, y Z. Guo (2017), se propone un sistema de apuestas deportivas descentralizado basado en contratos inteligentes. Los autores describen cómo los contratos inteligentes pueden ser utilizados para automatizar el proceso de apuestas, eliminar la necesidad de intermediarios y garantizar la transparencia de las transacciones. El artículo también analiza los desafíos técnicos y legales asociados con la implementación de este tipo de sistema.

En el informe «Decentralized Gambling: A Survey of Blockchain-Based Applications» por A. Narayanan (2017), publicado por el Centro de Estudios Monetarios Internacionales, se proporciona una descripción general de las aplicaciones de blockchain para el juego descentralizado. El autor analiza diferentes tipos de aplicaciones, incluyendo plataformas de apuestas, juegos de azar y loterías. El informe también identifica los principales desafíos y oportunidades asociados con la descentralización del juego, y concluye que la tecnología blockchain tiene el potencial de revolucionar esta industria.

Solución Propuesta

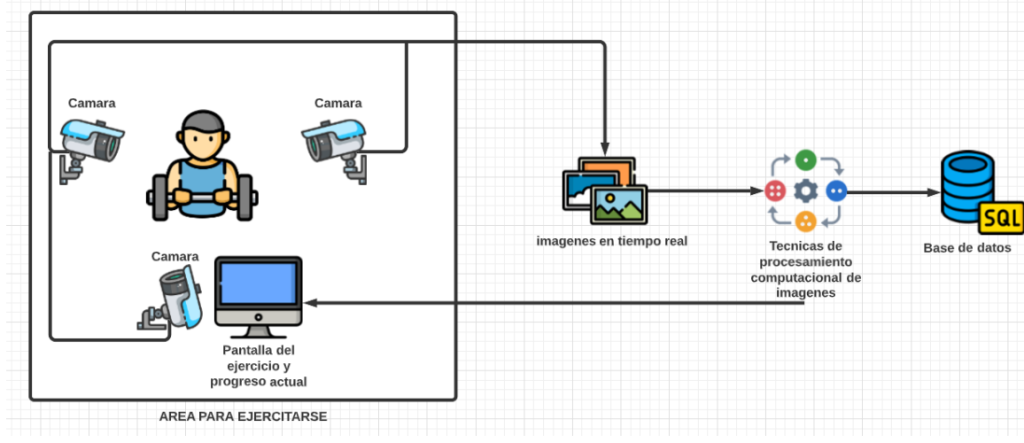

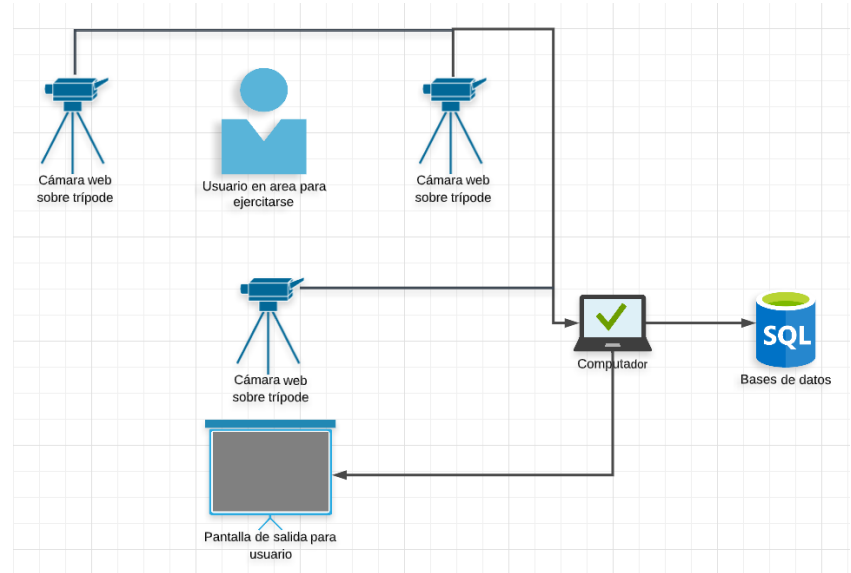

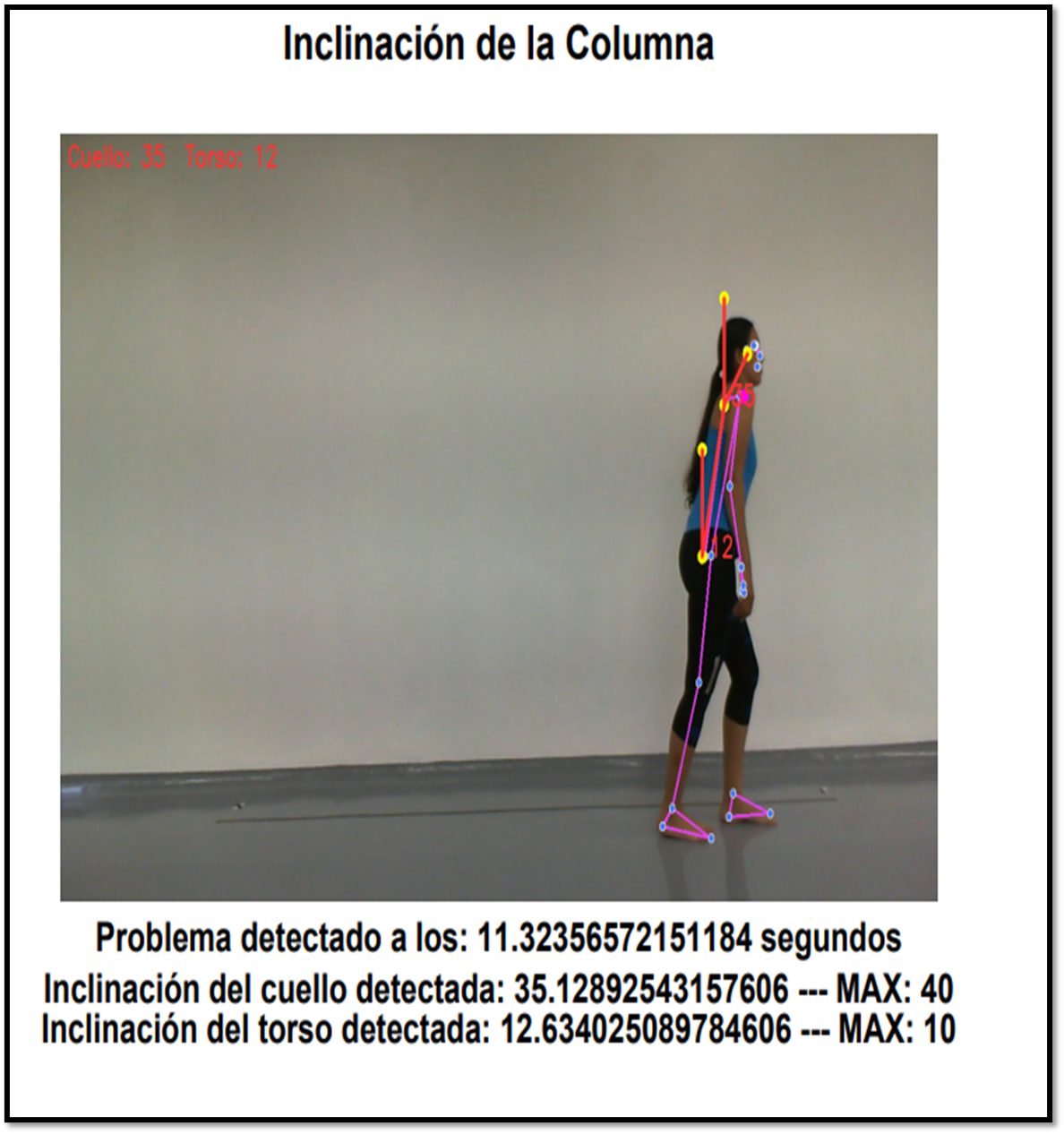

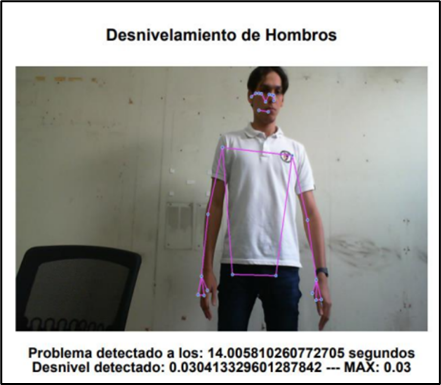

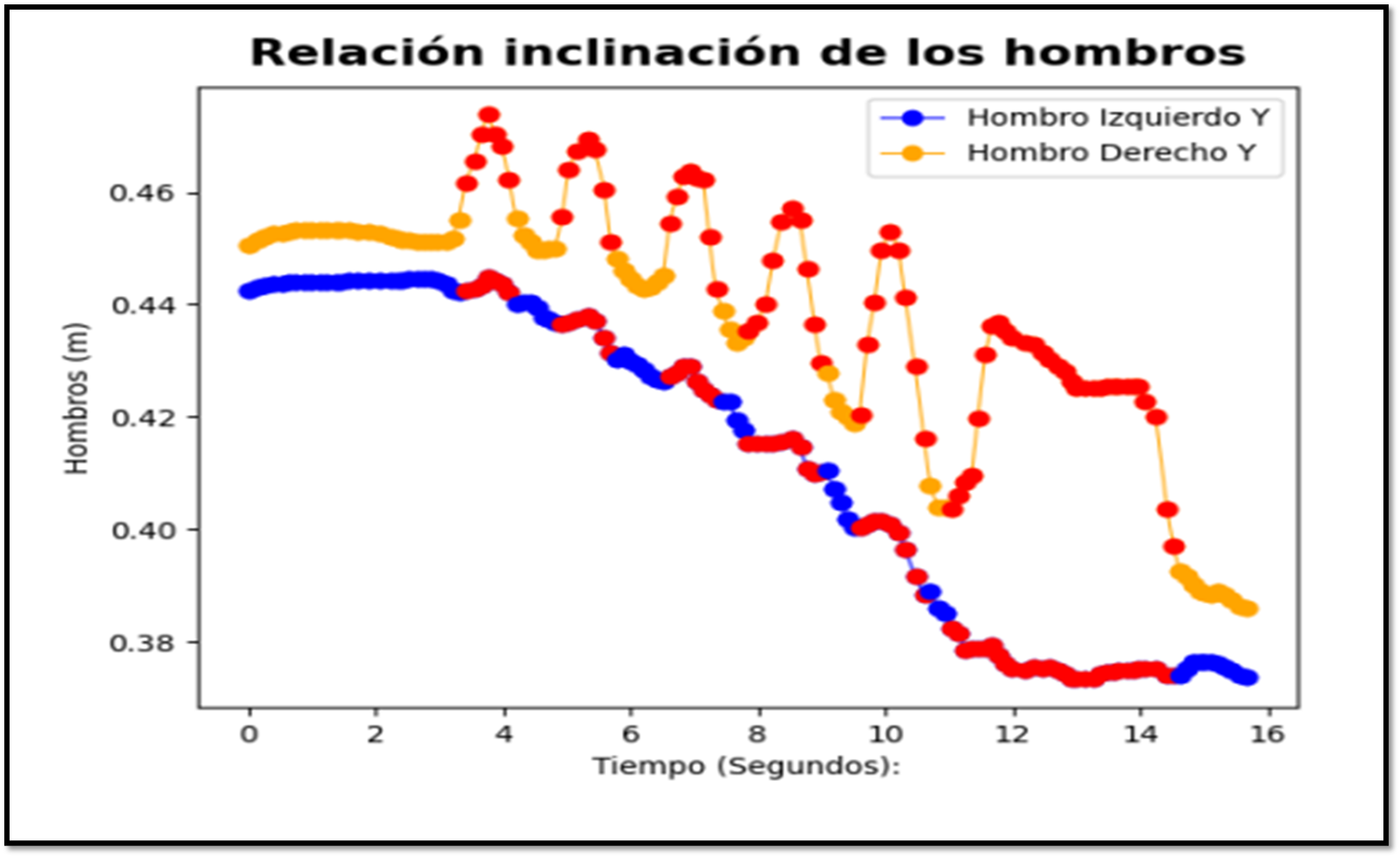

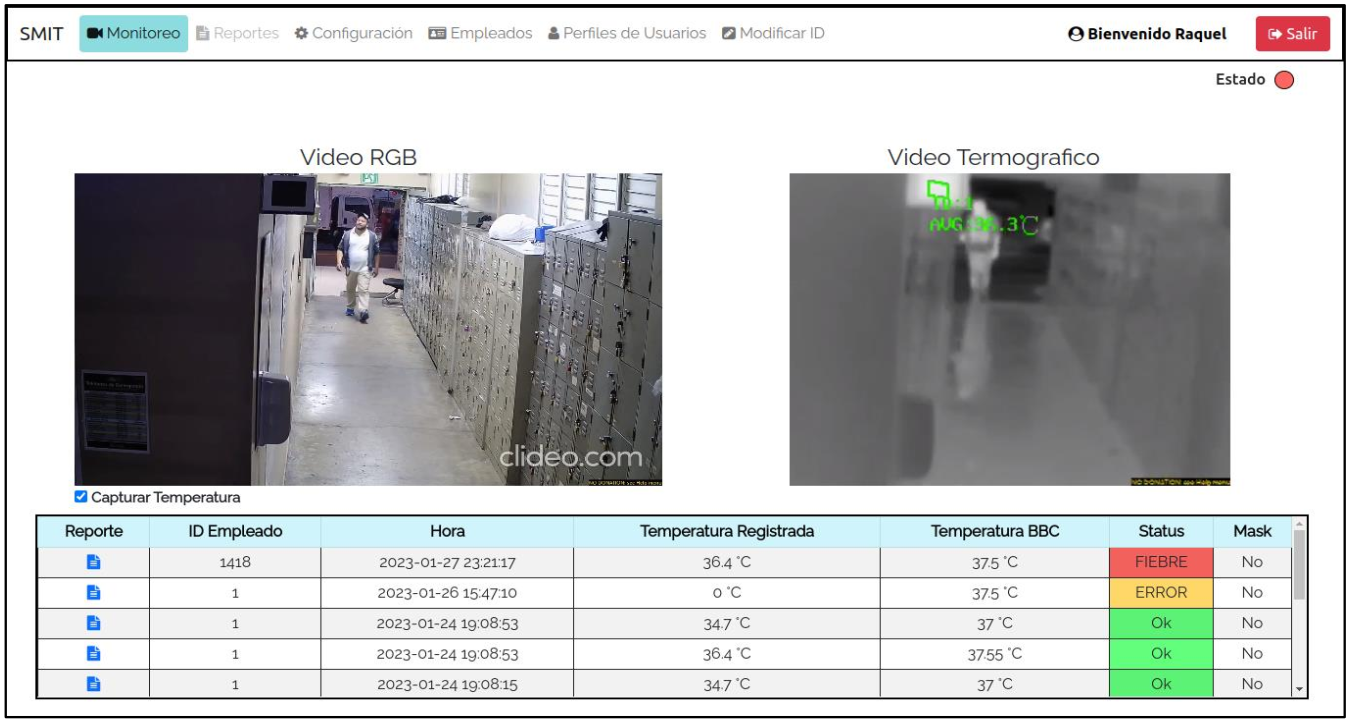

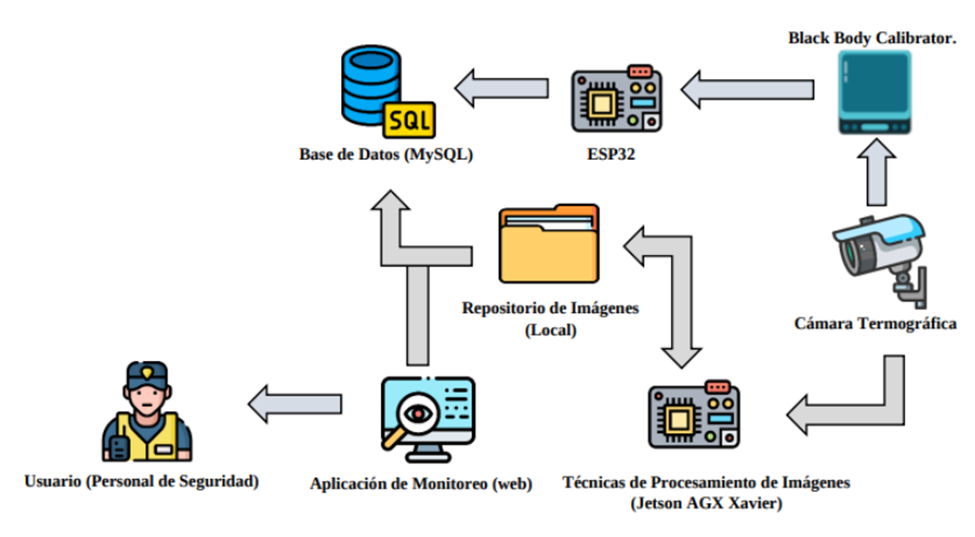

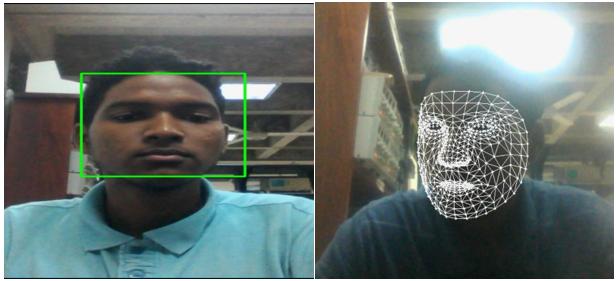

Por esta razón, se desarrolló una aplicación que determina mediante visión computacional si el usuario ejecuta de manera ópt

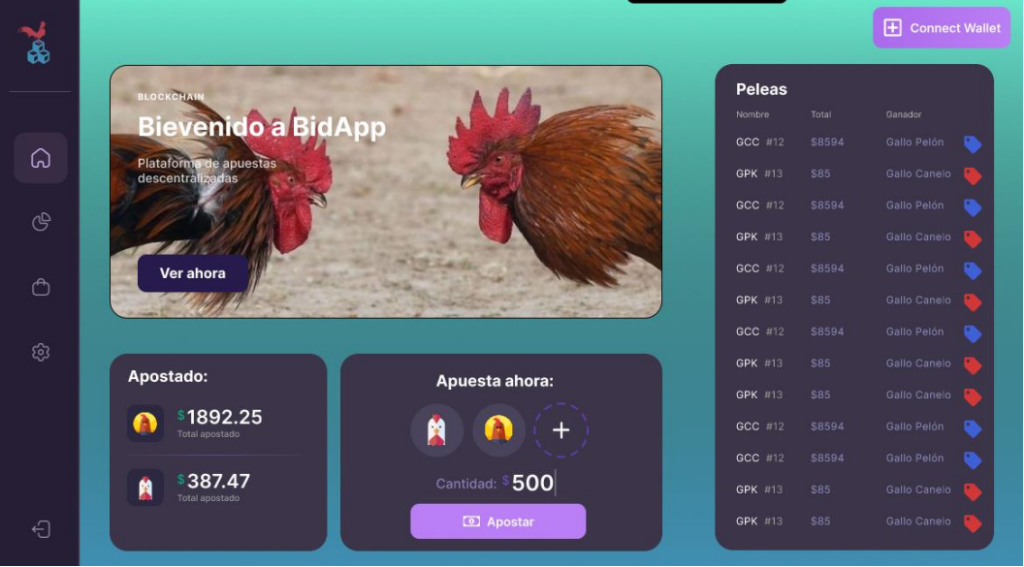

Como solución a dicho problema, se propone la creación de una plataforma que permita gestionar el proceso de creación y finalización de peleas de gallos, permitiendo la apuesta de los participantes en cada pelea y la visualización de estas en vivo. Todo esto utilizando contratos inteligentes que sirven como reglas automáticas que se activaran cuando una de las reglas fijadas entre una de las dos partes realice alguna acción.

La adopción de tecnología emergente como el uso de criptomonedas representa una oportunidad para innovar en este campo, atrayendo nuevos participantes y modernizando esta práctica tradicional. En conclusión, se busca lograr atraer nuevos participantes y el crecimiento del mercado local, buscando nuevas personas que se integren sin necesidad de ir de forma presencial a la gallera.

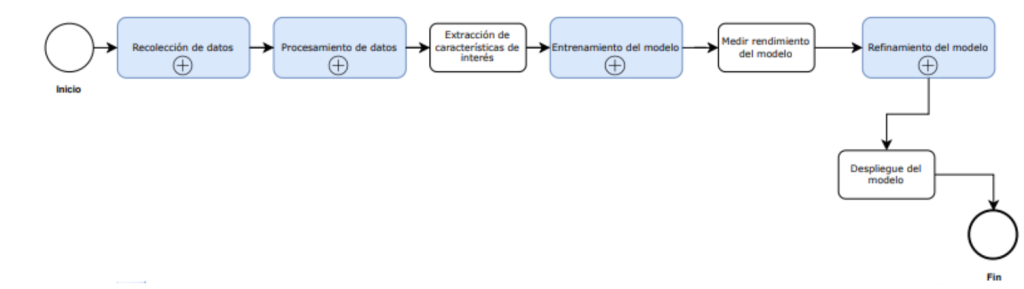

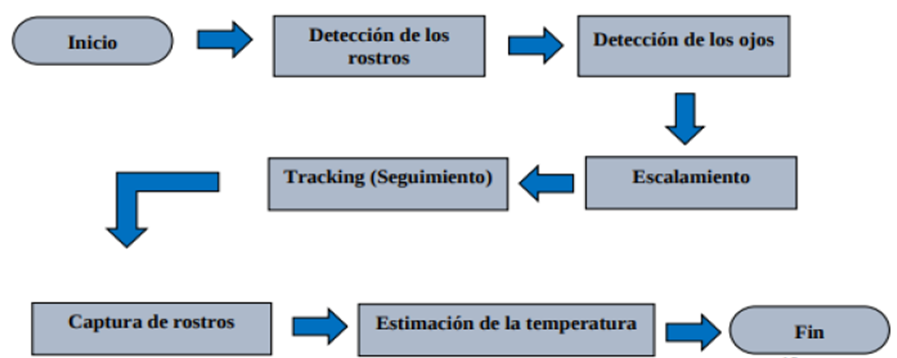

Metodología

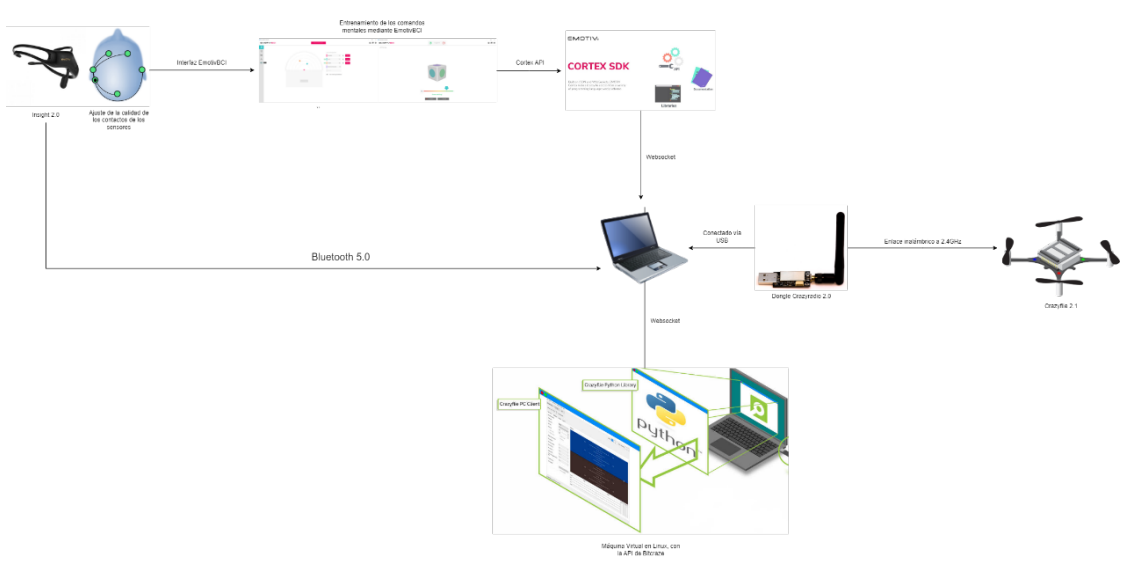

Para facilitar la lógica dentro de la plataforma web, se va a implementar cadena de bloques o “blockchain”. Este es un libro de contabilidad que permite el registro de transacciones, seguimiento y creación de reglas que se ejecutan de forma automática. Mas específicamente dentro de este término, los contratos inteligentes se deben de ver como un conjunto de reglas definidas que están almacenadas en una cadena de bloques, se ejecutan cuando se cumplen las condiciones definidas, y que no son modificables y son autónomos. Estas condiciones se establecen utilizando una cadena de bloques o blockchain, la cual nos permite distribuir nuestro contrato a través de la red, asegurando que no se pueda modificar.

Resultados Obtenidos

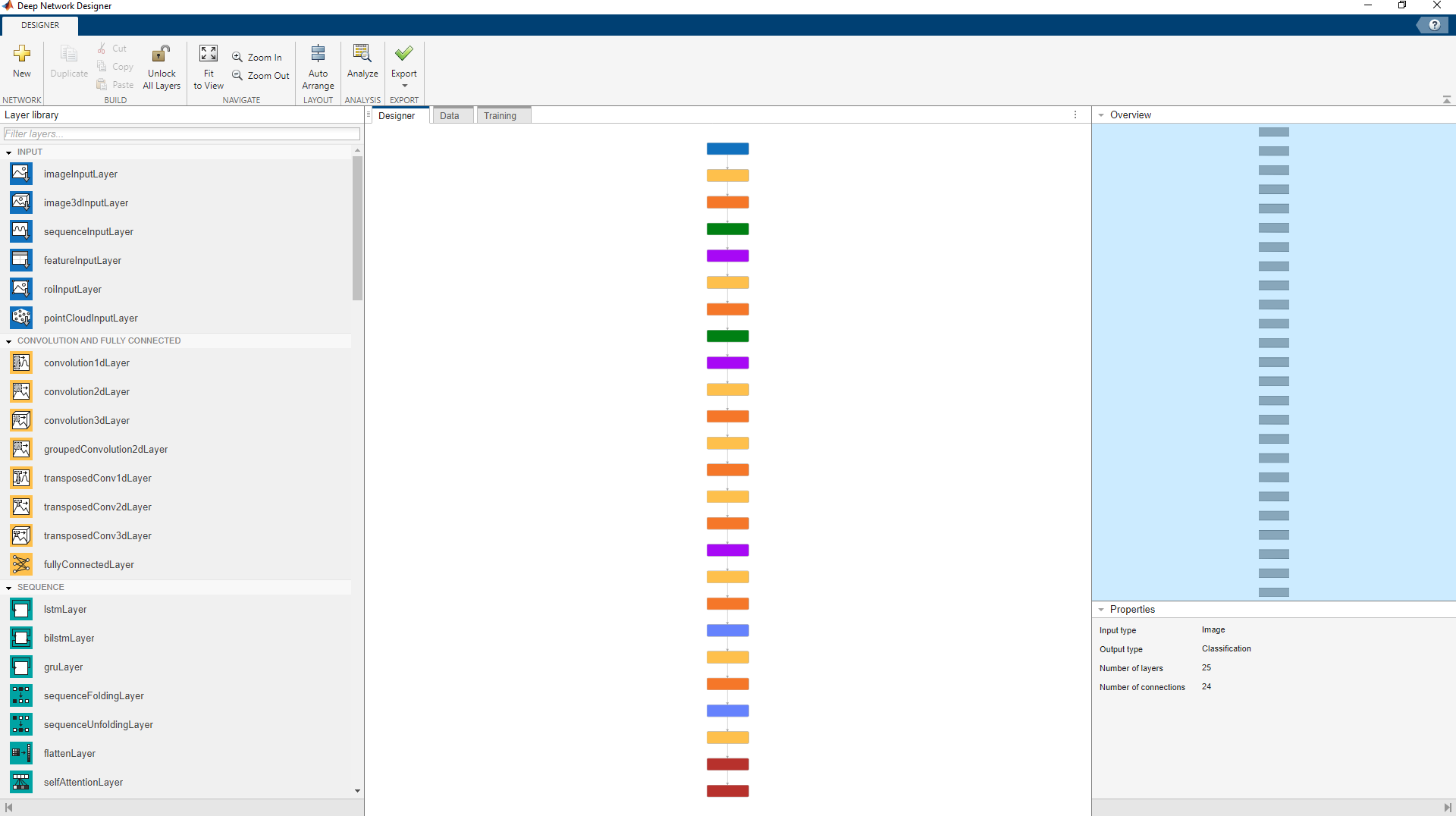

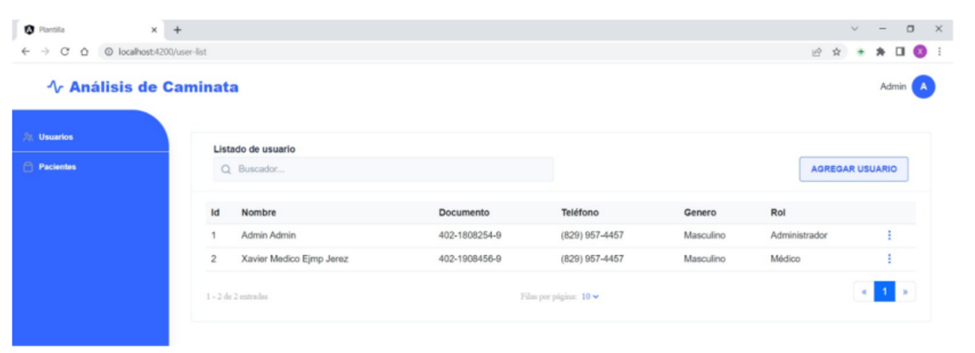

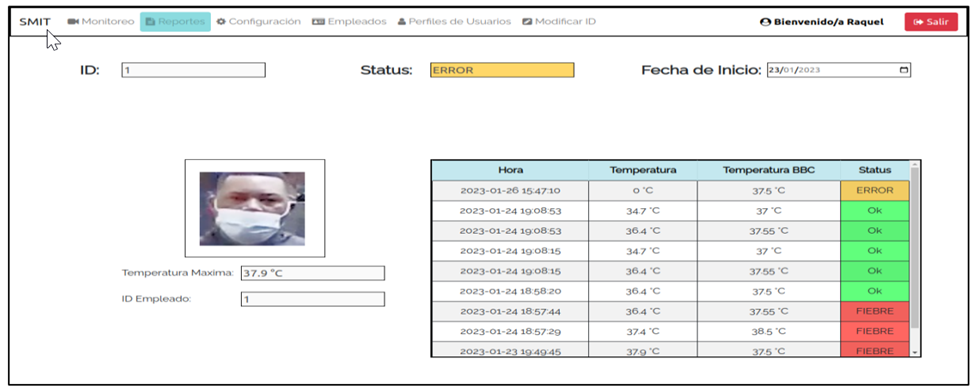

Se realizó un desarrollo de un cliente web, basado en el tipo de implementación web SPA utilizando Vue3.js. Para el desarrollo de los contratos inteligentes, como se puede observar en la figura 19, se desarrollaron basándose RoostApp 49 en el patrón de diseño Factory. Este patrón nos permite generar otros contratos a partir de un contrato existente.

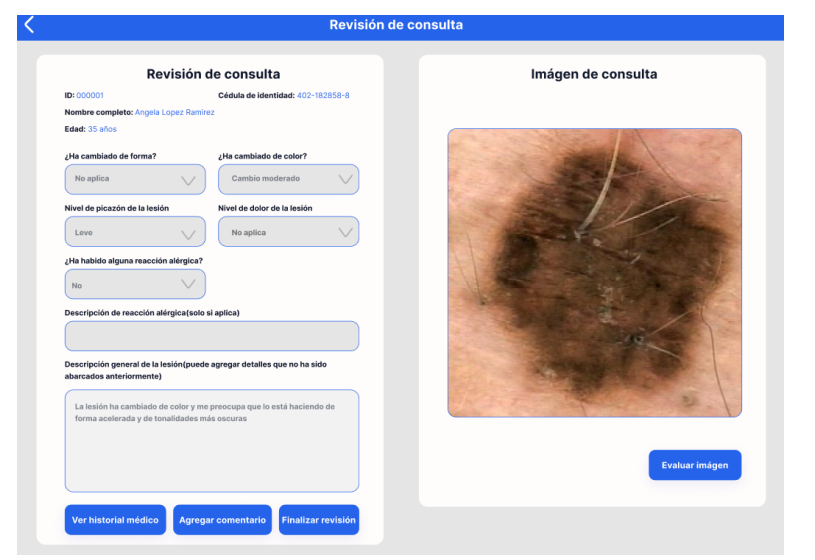

De esta manera se llego a obtener una aplicación móvil totalmente funcional, preparada para registrar galleras, registrar jugadas, ser transparente en la repartición de beneficios y segura e intuitiva.

Además, se entiende que se cuenta con una interfaz cómoda e intuitiva para nuevos usuarios como para veteranos y con una recopilación de datos fiable y eficiente para el análisis temporal como para posterior evaluación.

Conclusiones

Esto culminó en el desarrollo e implementación de una aplicación web funcional que permitía transacciones para múltiples usuarios y el uso eficiente de contratos inteligentes.

Se encontraron algunos desafíos inesperados, como el uso excesivo de gas para las transacciones, lo que nos llevó a optimizar los contratos para reducir costos operativos.

Una limitación importante fue la negativa de algunas de las plataformas que tienen los derechos de la mayoría de los coliseos en el país, a transmitir sus peleas en la plataforma. La colaboración con ellos sería crucial para la viabilidad económica del proyecto, ya que las galleras tradicionales carecen de la infraestructura necesaria.

Recomendaciones

Para mejorar la viabilidad y desarrollo de la aplicación, se recomienda integrar mejoras no contempladas inicialmente, como el uso de stablecoins para evitar la volatilidad del Ether y proteger las ganancias de los usuarios. Además, sería beneficioso montar un nodo de Ethereum propio para no depender de servicios de terceros, y utilizar herramientas como Truffle o Hardhat para el desarrollo, pruebas y despliegue de contratos inteligentes, lo que aumentaría la velocidad y eficiencia del desarrollo. Finalmente, se sugiere explorar nuevas formas de colaboración con GalleroSoy o entidades similares para asegurar la viabilidad económica y la disponibilidad de contenido relevante para la plataforma.

Referencias

- Rodriguez, N. (2022) Glosario definitivo de blockchain para principiantes – 46 definiciones de blockchain, 101 Blockchains. Available at: https://101blockchains.com/es/definiciones-de-blockchain/ (Accessed: 27 November 2023).

- Material design (no date) Material Design. Available at: https://m3.material.io (Accessed: 29 November 2023).

- Comenzar Con metamask – MetaMask (no date). Available at: https://support.metamask.io/hc/es/articles/360015489531-comenzar-con MetaMask (Accessed: 27 November 2023).(No date)

- Bitcoin: Economics, technology, and governance. Available at: https://pubs.aeaweb.org/doi/pdfplus/10.1257/jep.29.2.213 (Accessed: 27 November 2023).