Pontifica Universidad Católica Madre y Maestra, PUCMM

Introducción

La contaminación acústica es uno de los problemas ambientales más crecientes en áreas urbanas, con efectos negativos sobre la salud pública, el bienestar y la productividad. Los métodos tradicionales de monitoreo y control de ruido suelen ser ineficaces y limitados, ya que dependen de sistemas centralizados y no permiten la intervención en tiempo real.

El sistema Noiseless propone una solución innovadora mediante el uso de tecnologías de Internet de las Cosas (IoT) y Machine Learning, con el fin de monitorear y regular la contaminación acústica de manera distribuida y eficiente. Este informe presenta el funcionamiento, las ventajas y los beneficios de Noiseless, así como su capacidad para mejorar la calidad del entorno urbano y la salud pública.

Contexto

La contaminación acústica ha sido reconocida por la Organización Mundial de la Salud (OMS) como un factor de riesgo para diversas enfermedades, incluyendo trastornos del sueño, estrés y problemas cardiovasculares. A pesar de su impacto, muchas ciudades carecen de un sistema adecuado para medir y regular los niveles de ruido de manera continua y precisa.

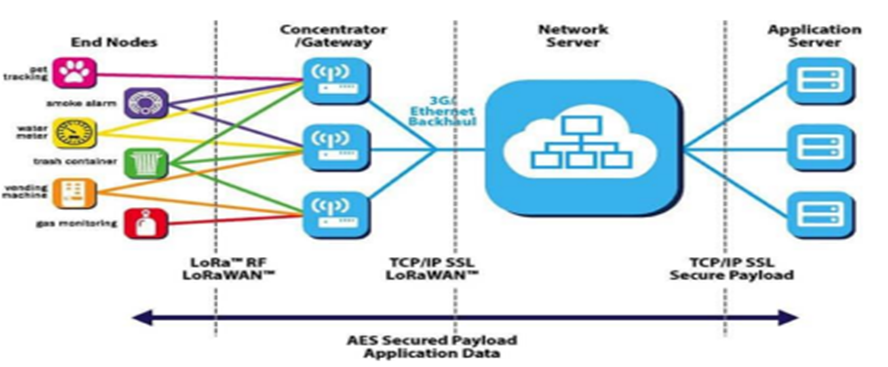

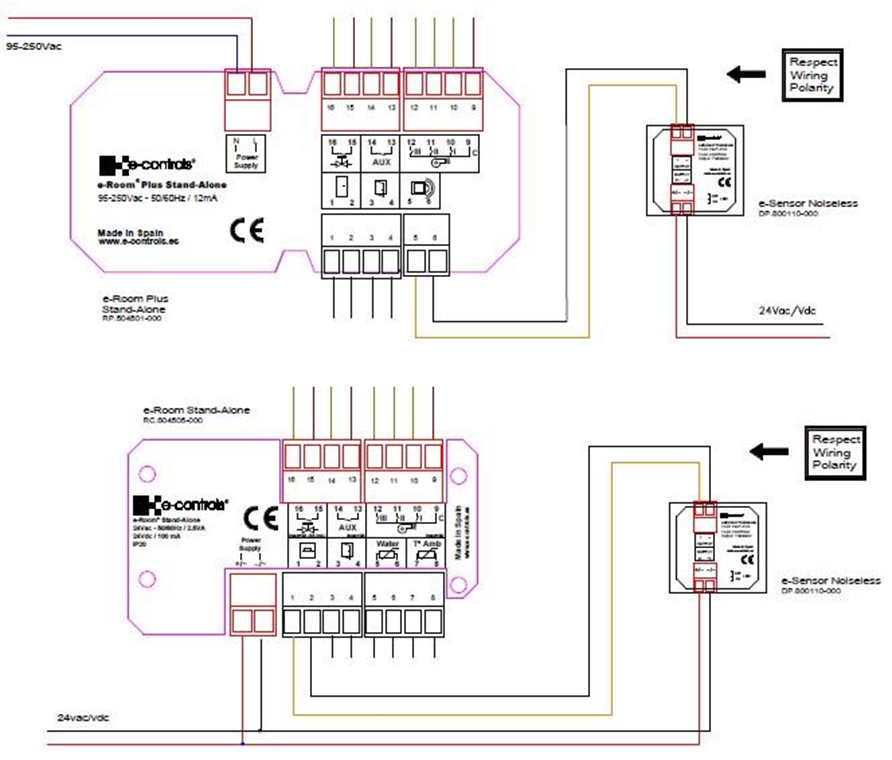

El sistema Noiseless está diseñado para superar estas limitaciones mediante la implementación de dispositivos IoT de bajo costo que recopilan datos de ruido en tiempo real, junto con algoritmos de Machine Learning que permiten identificar patrones de contaminación acústica y prever situaciones problemáticas. Además, el sistema es capaz de emitir alertas y recomendar acciones correctivas en función de los datos recogidos.

Proyectos Relacionados

Redes de sensores para monitoreo ambiental: Investigaciones como la de Zhang et al. (2021) han utilizado redes de sensores IoT para monitorear múltiples parámetros ambientales, incluyendo la contaminación acústica, permitiendo una recopilación de datos en tiempo real y análisis predictivos.

Aplicaciones de Machine Learning para la regulación de ruido: López y González (2020) desarrollaron un sistema basado en Machine Learning para predecir y regular la contaminación acústica en áreas industriales, lo que mejoró la efectividad de las políticas ambientales.

Sistemas de monitoreo de ruido en ciudades inteligentes: Kumar et al. (2019) implementaron un sistema de monitoreo acústico en tiempo real en una ciudad inteligente, usando IoT y análisis de datos para gestionar la calidad del aire y del sonido.

Solución Propuesta

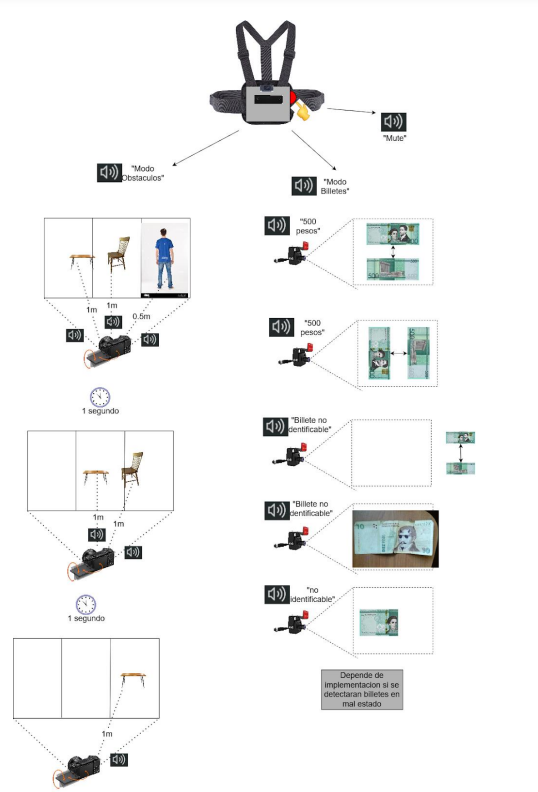

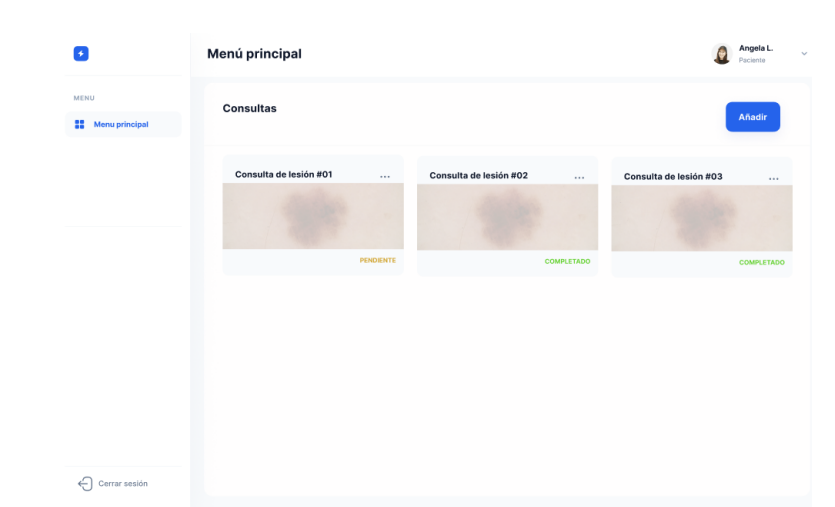

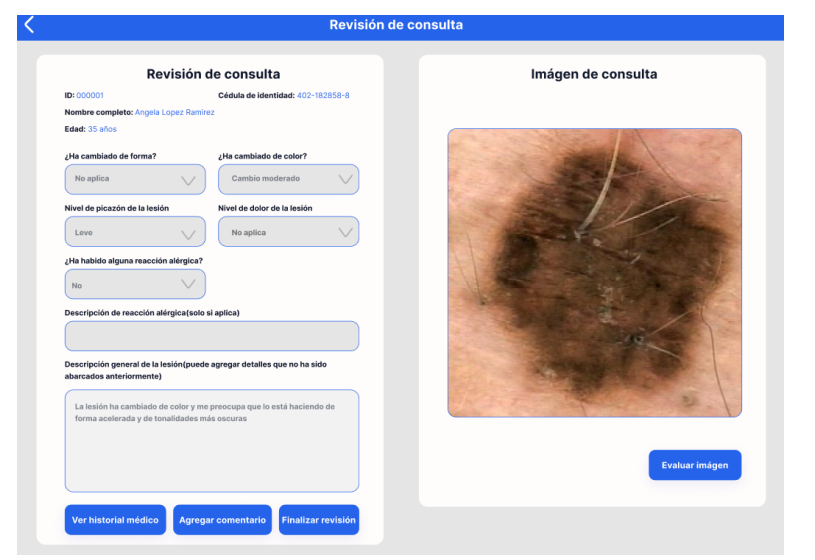

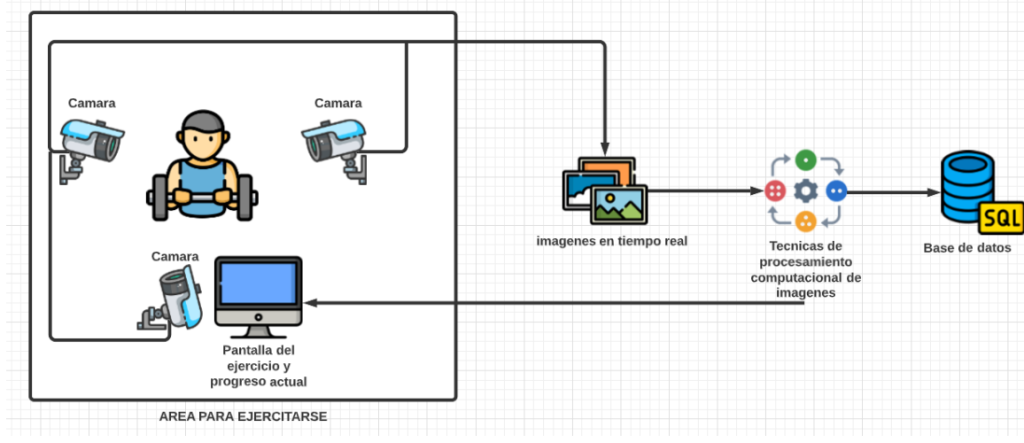

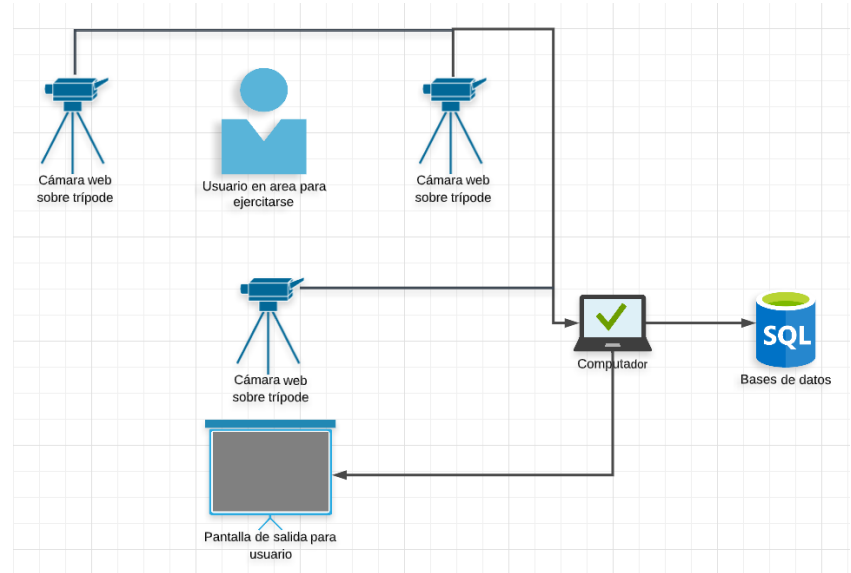

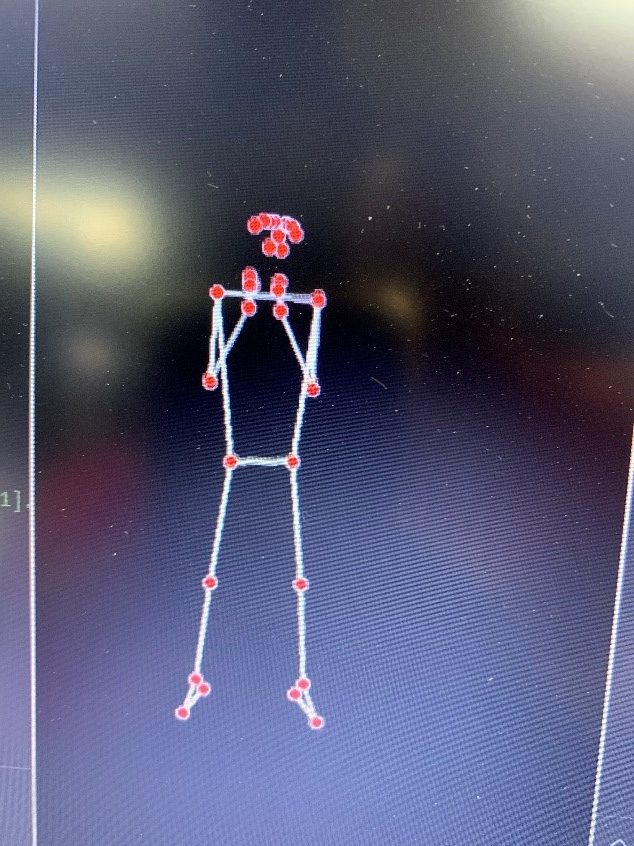

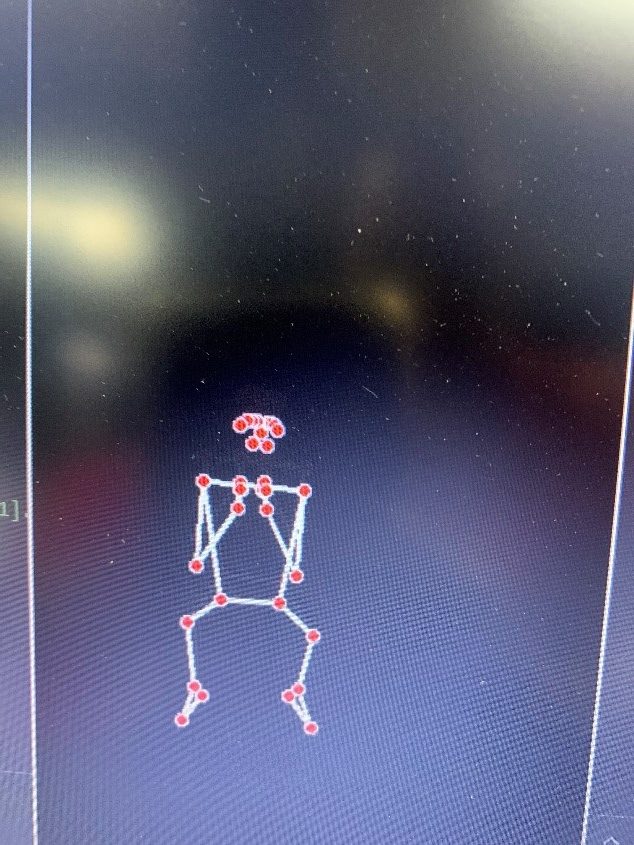

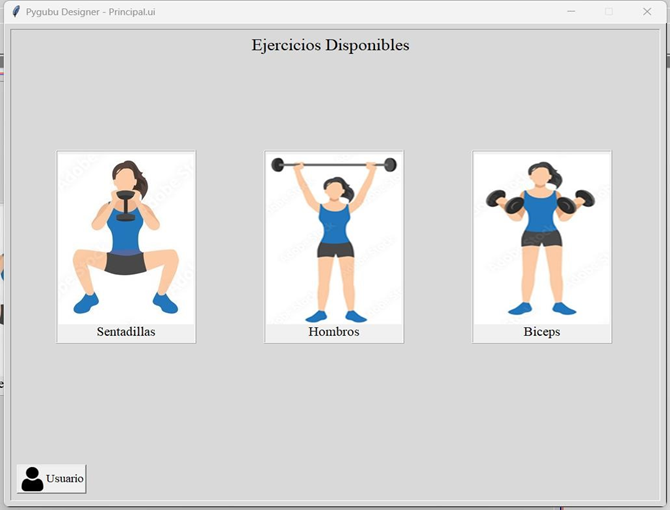

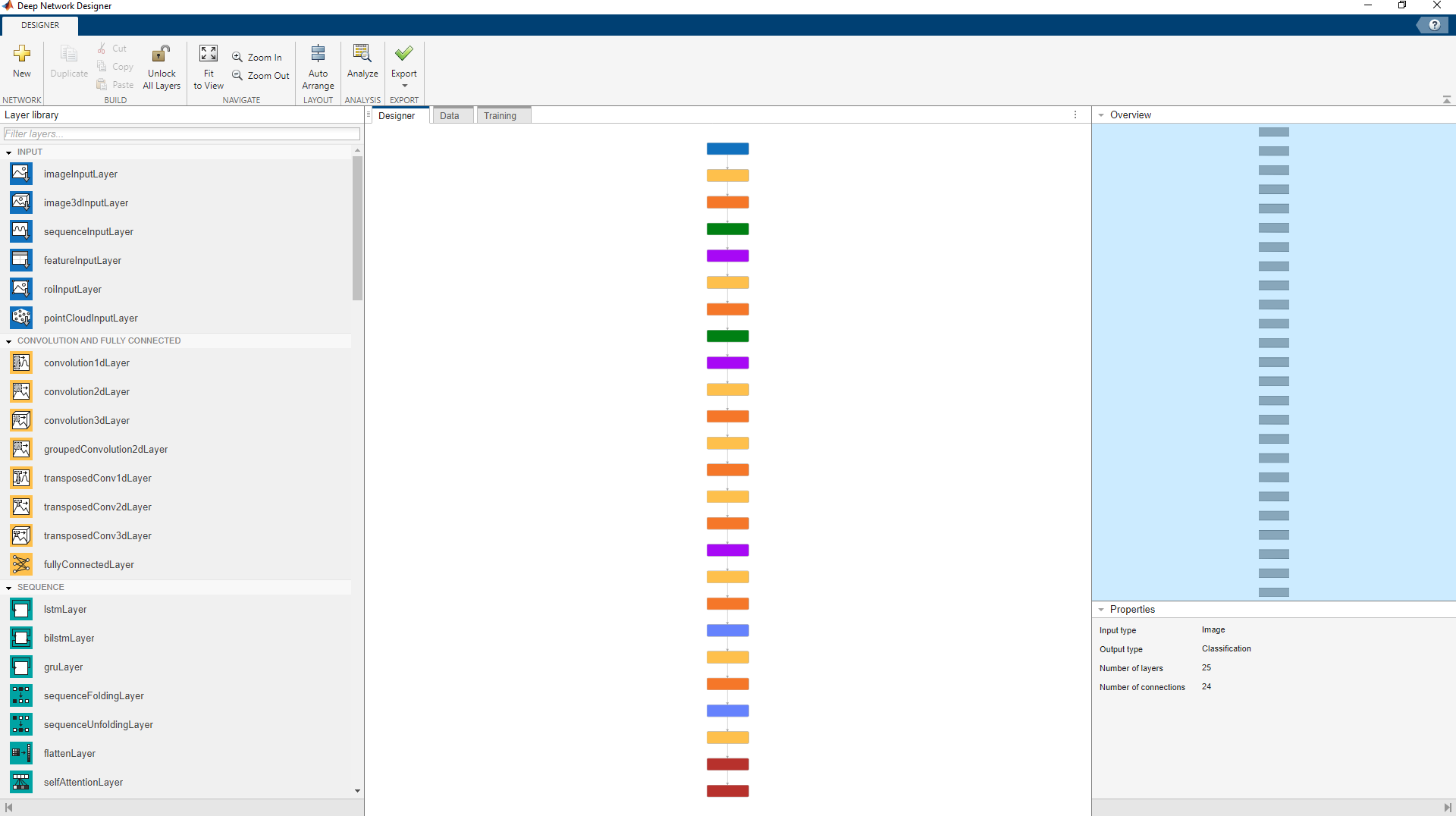

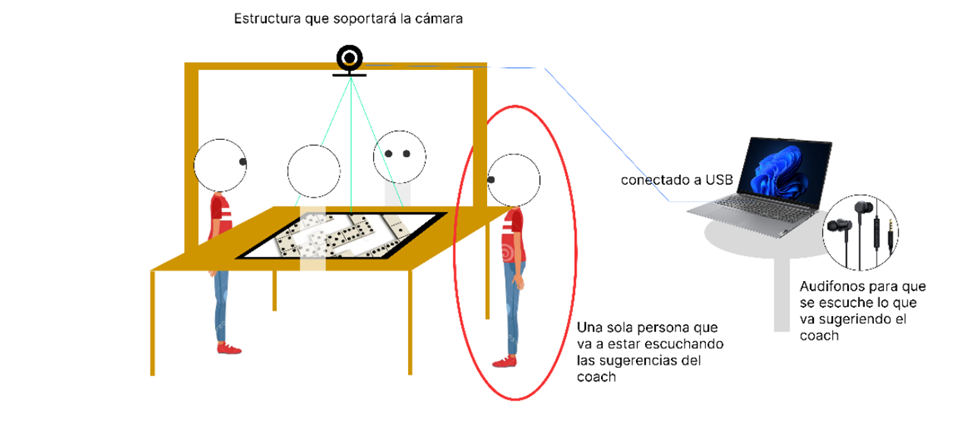

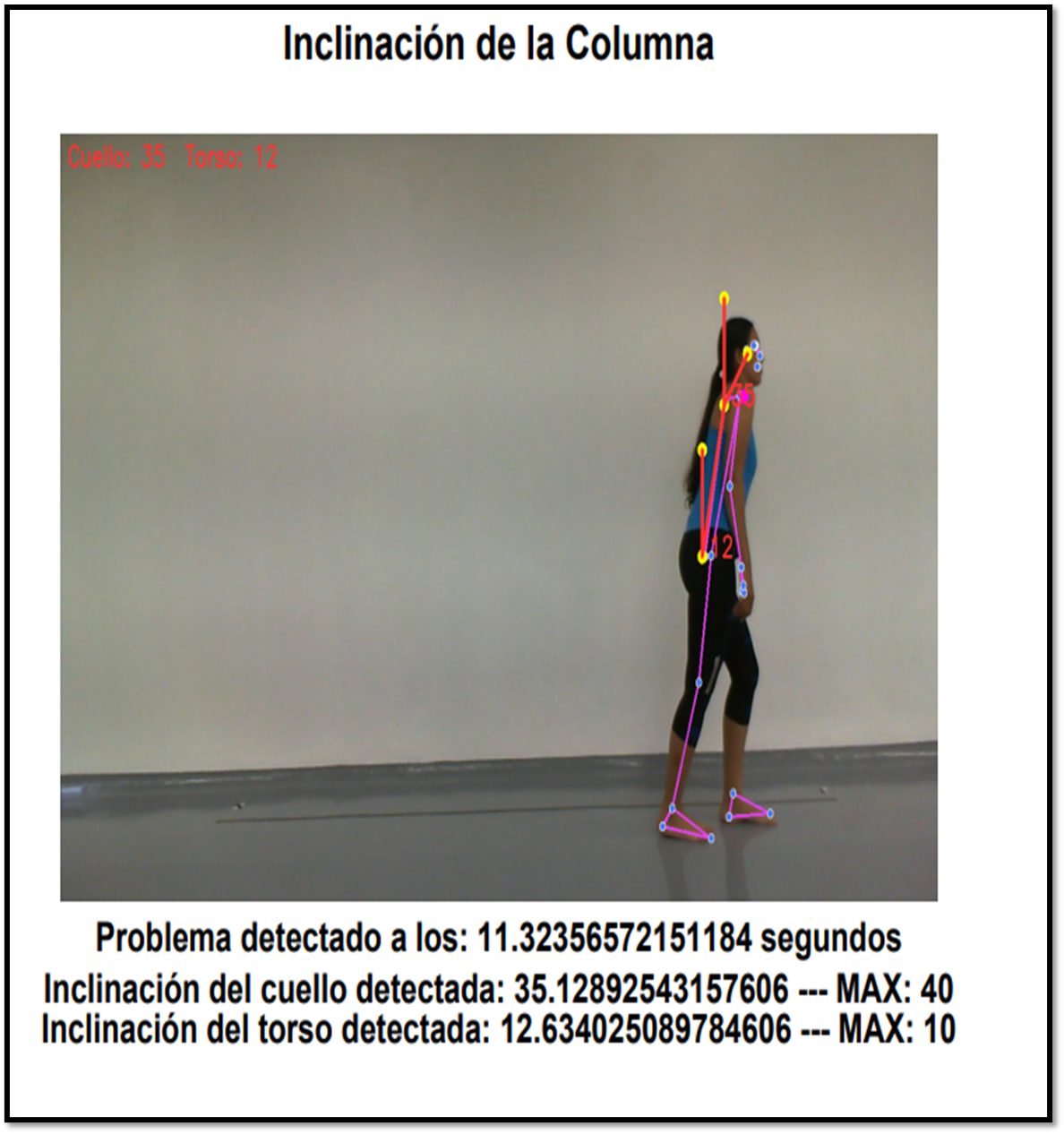

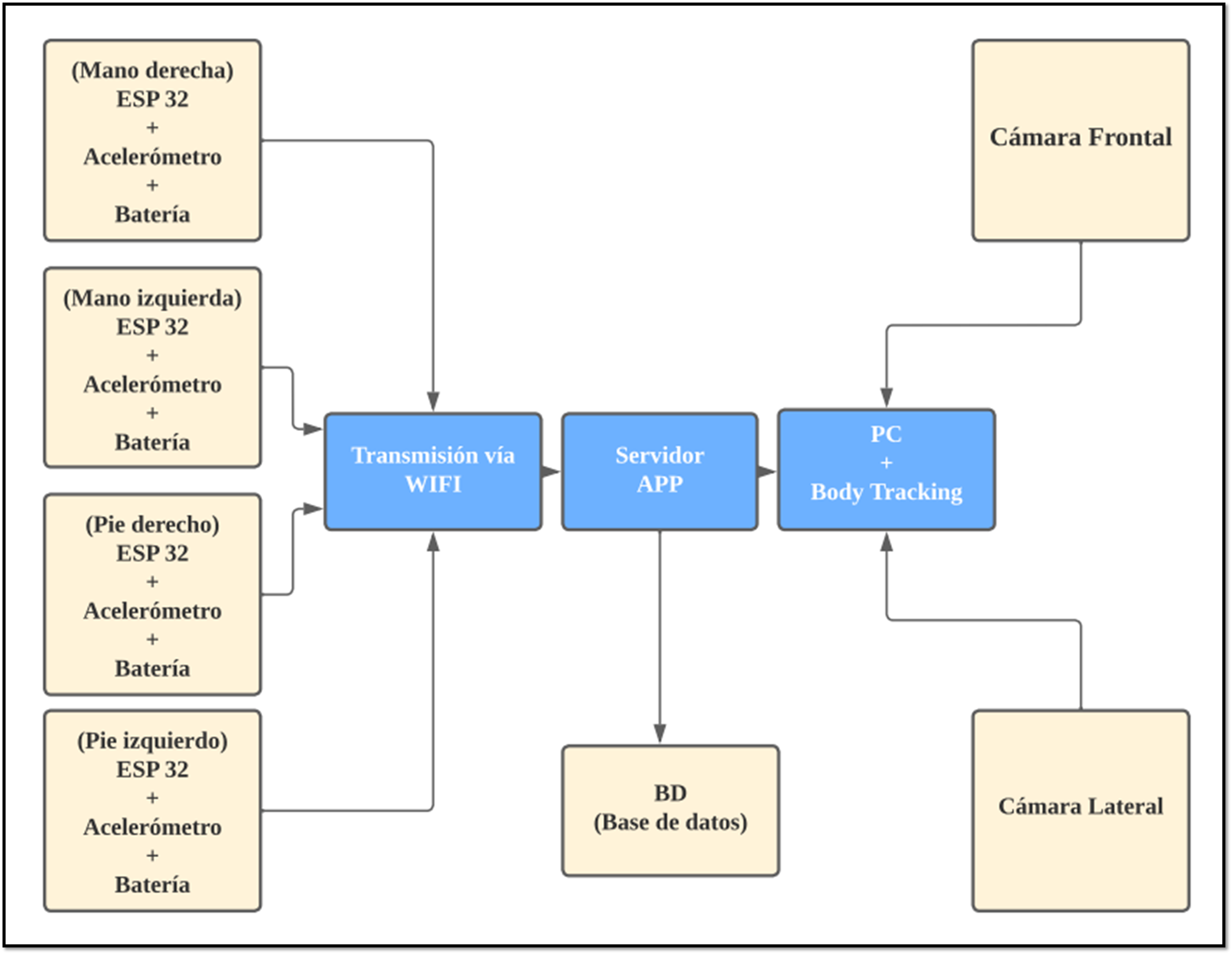

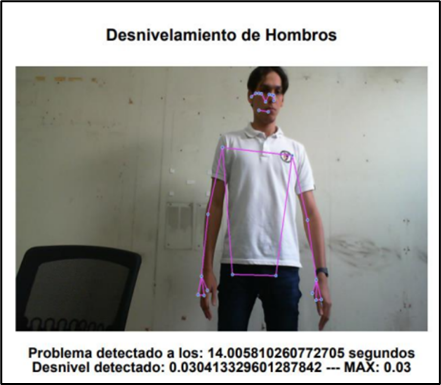

Por esta razón, se desarrolló una aplicación que determina mediante visión computacional si el usuario ejecuta de manera ópt

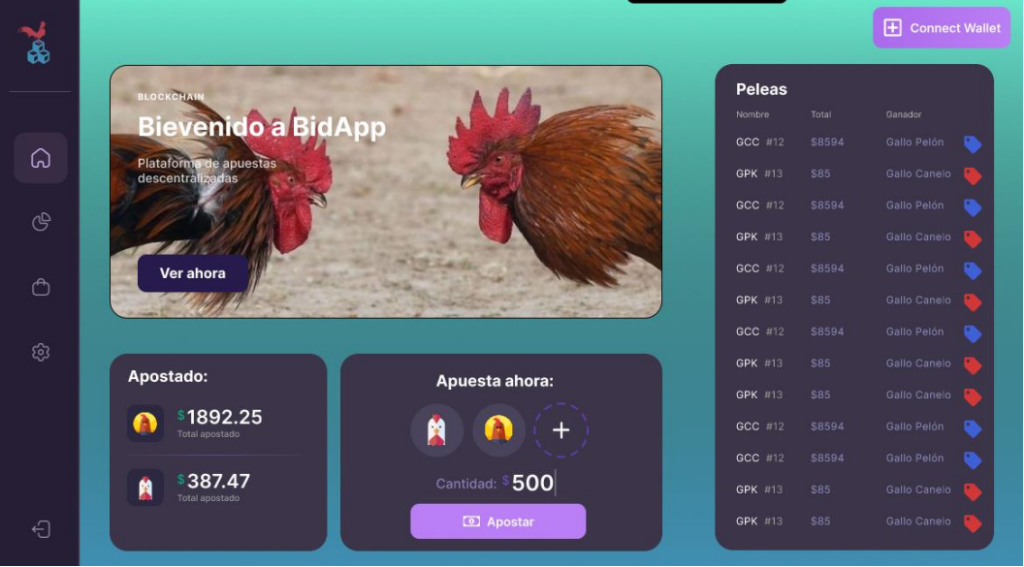

Como solución a dicho problema, se propone la creación de una plataforma que permita gestionar el proceso de creación y finalización de peleas de gallos, permitiendo la apuesta de los participantes en cada pelea y la visualización de estas en vivo. Todo esto utilizando contratos inteligentes que sirven como reglas automáticas que se activaran cuando una de las reglas fijadas entre una de las dos partes realice alguna acción.

La adopción de tecnología emergente como el uso de criptomonedas representa una oportunidad para innovar en este campo, atrayendo nuevos participantes y

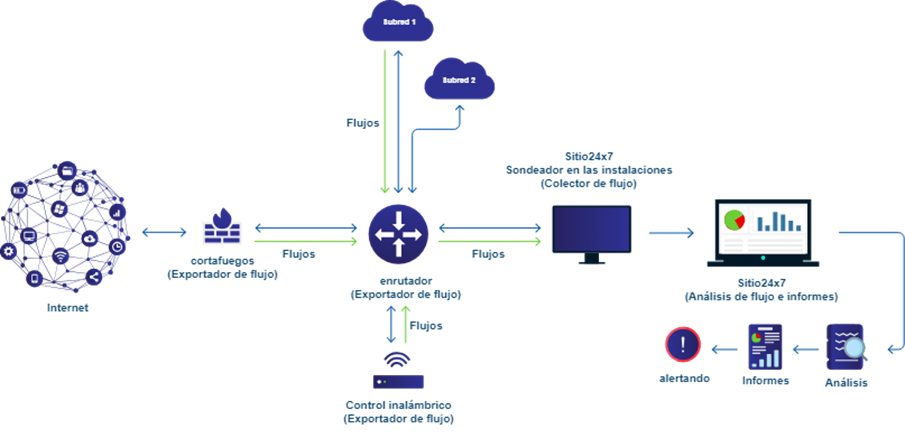

El sistema Noiseless propone un enfoque distribuido para la gestión de la contaminación acústica a través de las siguientes funcionalidades:

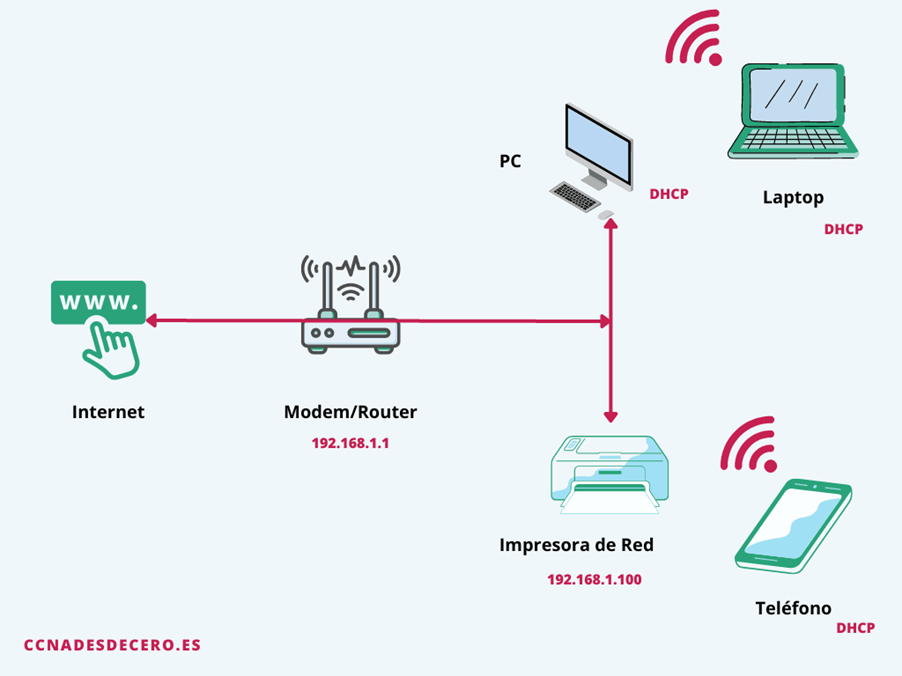

Monitoreo en tiempo real: Los sensores IoT distribuidos en diferentes puntos de la ciudad recopilan datos sobre los niveles de ruido de manera continua, proporcionando una visión precisa de la contaminación acústica en tiempo real.

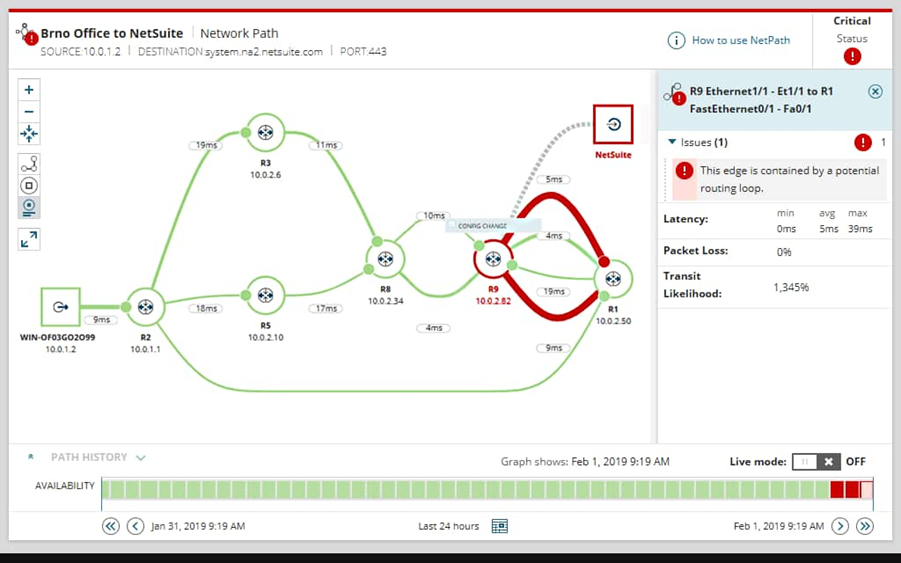

Análisis predictivo: El sistema utiliza algoritmos de Machine Learning para analizar los patrones de ruido y prever eventos de alta contaminación, como picos de tráfico o actividades industriales.

Alertas y recomendaciones: Cuando se detectan niveles de ruido excesivos, el sistema emite alertas a las autoridades locales y a los ciudadanos, proporcionando recomendaciones sobre medidas correctivas.

Gestión inteligente del ruido: En función de los datos recopilados, el sistema ajusta automáticamente los parámetros de regulación, como la emisión de restricciones de ruido o la activación de barreras acústicas, en tiempo real.

modernizando esta práctica tradicional. En conclusión, se busca lograr atraer nuevos participantes y el crecimiento del mercado local, buscando nuevas personas que se integren sin necesidad de ir de forma presencial a la gallera.

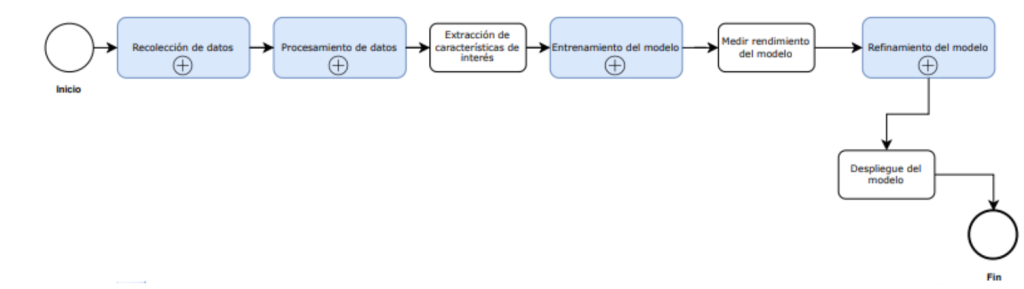

Metodología

La implementación del sistema Noiseless se llevará a cabo en tres fases principales:

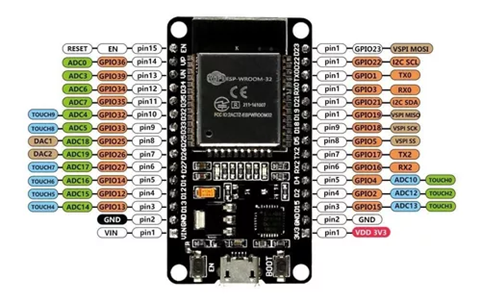

Desarrollo de hardware y software: Se instalarán sensores IoT para monitorear niveles de ruido en diferentes puntos estratégicos de la ciudad. Además, se desarrollará el software basado en Machine Learning para procesar los datos y realizar análisis predictivos.

Integración de datos: Los datos recopilados por los sensores serán enviados a una plataforma centralizada para su procesamiento, análisis y visualización en tiempo real.

Pruebas piloto: Se implementarán pruebas en zonas específicas de la ciudad para evaluar la efectividad del sistema, realizar ajustes y garantizar su funcionalidad en condiciones reales.

Resultados Obtenidos

Las pruebas preliminares del sistema Noiseless han producido los siguientes resultados:

Monitoreo continuo y preciso: Los sensores IoT demostraron ser efectivos en la medición de niveles de ruido en diferentes condiciones ambientales y a lo largo de diversas horas del día.

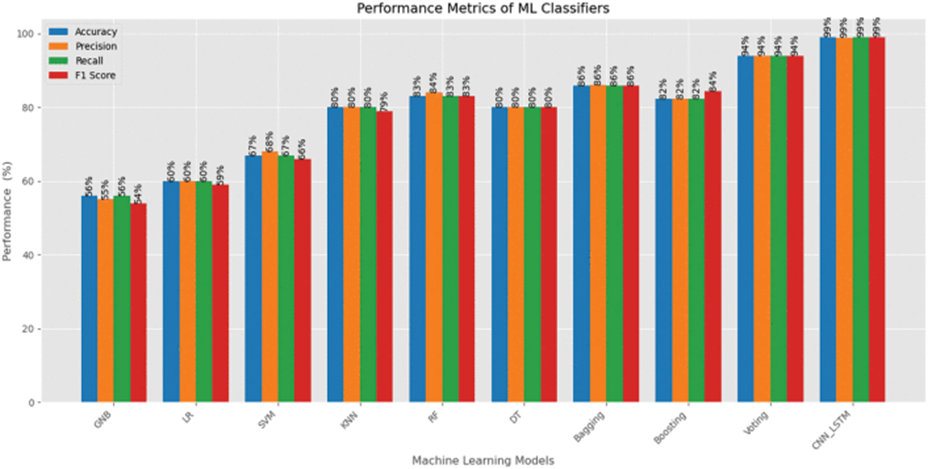

Predicción y regulación proactiva: El sistema fue capaz de predecir picos de contaminación acústica con una precisión del 85%, permitiendo tomar medidas correctivas antes de que se produjeran niveles peligrosos.

Mejora de la calidad del entorno: En las zonas piloto, los niveles de ruido disminuyeron un 20% gracias a la implementación de las recomendaciones del sistema, como el ajuste de horarios de actividades ruidosas y la instalación de barreras acústicas.

Conclusiones

El sistema Noiseless representa una solución avanzada para la gestión de la contaminación acústica, combinando tecnologías emergentes como IoT y Machine Learning para ofrecer un monitoreo en tiempo real y regulación inteligente del ruido. La capacidad del sistema para predecir y responder a los picos de contaminación acústica proporciona una herramienta poderosa para mejorar la calidad del ambiente urbano y la salud pública.

Recomendaciones

Ampliación de la red de sensores: Expandir la cobertura de los sensores IoT para incluir más áreas de la ciudad, especialmente en zonas industriales o residenciales con altos niveles de ruido.

Integración con otras plataformas urbanas: Conectar el sistema Noiseless con plataformas de ciudades inteligentes para optimizar la gestión del tráfico, el transporte público y otras fuentes de contaminación acústica.

Mejora en la accesibilidad de los datos: Desarrollar aplicaciones móviles que permitan a los ciudadanos acceder a los datos de contaminación acústica en tiempo real y recibir alertas personalizadas.

Referencias

-

[1] Zhang, L., et al. (2021). Redes de sensores IoT para monitoreo ambiental en tiempo real. Springer.

-

[2] López, M., & González, R. (2020). Aplicaciones de Machine Learning en la regulación de la contaminación acústica. Elsevier.

-

[3] Kumar, P., et al. (2019). Sistemas de monitoreo de ruido en ciudades inteligentes. Wiley.