Andrés Mauricio Estrella Espejo y John Harold Peña Acosta

Pontifica Universidad Católica Madre y Maestra, PUCMM

Introducción

Los sentidos corporales son nuestros interpretadores del mundo que nos rodea. Los seres humanos tenemos cinco sentidos: la vista, el gusto, el olfato, el oído y el tacto que percibimos a través de ojos, lengua, nariz, oídos y piel, respectivamente. Según los investigadores Dr. L.D. Rosenblum y el Dr. Harold Stolovitch, La cantidad de información que cada uno de nuestros sentidos procesa al mismo tiempo en comparación con nuestros otros sentidos es la siguiente; 83% Vista, 11% Oído, 3.5% Olfato, 1.5% Tacto y 1% Gusto. Esto nos permite inferir que las personas con discapacidad visual son más propensas a tener dificultades para la percepción de información y además tienden a tener mayor dificultad en su vida cotidiana.

Por esto y otras razones, este proyecto se limitará a brindar solución a las problemáticas de identificación de dinero e identificación de obstáculos.

Contexto

En la República Dominicana (2014) se estima que “hay unas 33 mil personas, en edades comprendidas entre los 18 y 65 años, totalmente ciegas de ambos ojos, quienes representan el 0.34% de la población” (ver referencia 3, sección de referencias). Muchas de estas personas se enfrentan a diario a los retos identificados anteriormente.

Proyectos Relacionados

Para la solución de la problemática planteada, Robert K. Katzschmann desarrolló su propio sistema de equipos electrónicos denominado ALVU (Array of Lidars and Vibrotactile Units). Su dispositivo consta de 2 cinturones, uno con motores vibratorios que brindan retroalimentación y otro compuesto por un conjunto de 7 sensores LIDAR apuntando en todas direcciones.

Este producto también contiene un conjunto de sensores, en este caso ultrasónicos y sensores ToF (Time of Flight) y brinda retroalimentación de manera háptica mediante vibraciones. Otra clase de este tipo de proyectos buscan rediseñar el clásico bastón blanco y mejorarlo con sensores y motores que guían al usuario fuera de los obstáculos.

B. Li et al., en “Vision-Based Mobile Indoor Assistive Navigation Aid for Blind People,” detecta obstáculos dinámicos y ajusta la ruta planeada en tiempo real. Primero toma información geométrica de planos arquitectónicos y genera un mapa semántico formado por una capa global transitable en 2D y capas sensibles al contexto. Logra localizar al usuario diseñando un algoritmo de alineación de mapas para unir el archivo de descripción del área visual (ADF) y el mapa semántico. Usando la cámara RGB-D integrada, desarrolla un detector de obstáculos eficiente basado en un algoritmo de filtro Kalman de mapa con marca de tiempo (TSM-KF).

Solución Propuesta

La solución consiste en un dispositivo vestible, llevado en el pecho mediante un arnés. Contiene el hardware adecuado para poder ejecutar un repertorio de software que aumente la calidad de vida de las personas con discapacidades visuales haciendo uso de visión computacional.

El repertorio de software consta de una multitud de aplicaciones que asisten en tareas cotidianas, a modo de ejemplo, algunas de estas aplicaciones serían: lector de textos, desde etiqueta de alimentos hasta libros, navegador GPS, videollamada con una persona para asistencia al usuario en situaciones que requieran de una ayuda más minuciosa, identificador de cartas para juegos de mesa, entre algunos otros.

El proyecto se centra en soluciones con enfoque visual, apoyándose únicamente de sensores de imágenes. Se capturan imágenes del ambiente del usuario, el sistema procesa dichas imágenes y se brinda retroalimentación auditiva en base a los resultados.

El algoritmo extractor de características implementado en el proyecto es conocido como “Oriented FAST and Rotated BRIEF” (ORB), este fue elegido tras investigar comparativas de algoritmos de la misma categoría ya que brindaba el mejor rendimiento en la mayoría de los casos y también está bajo licencia de software libre.

El resultado del proyecto será un producto completamente funcional, que se describe como prototipo debido a que no tendrá un diseño industrial, listo para la venta en el mercado. Por igual, tampoco tendrá una distribución de energía eficiente que le permita estar encendido por muchas horas, si no lo necesario para desarrollo y pruebas.

Metodología

Este proyecto es en fundamento un proyecto de visión computacional. Muchos problemas pueden ser abordados por la visión computacional, por ejemplo: reconocimiento facial, lectura de caracteres, clasificación de imágenes, etc.

Por eso, como primer paso del modelo, las imágenes capturadas son tomadas como entrada inicial del sistema. Posteriormente, la imagen capturada se procesa para obtener como salida la denominación de algún billete o la identificación de algún obstáculo. Posteriormente, la conversión de las imágenes de color a escala de grises es útil porque simplifica la cantidad de información contenida en una imagen, permitiendo al sistema realizar más operaciones complejas en menos tiempo, para después implementar en el sistema la detección de bordes es a través de Canny Edge Detection, ya que este proporciona mejores resultados en comparación con otros métodos. La detección de bordes se utiliza en complemento con segmentación de imágenes para extraer un área de interés al cual se le realizan varias operaciones en etapas posteriores.

Resultados Obtenidos

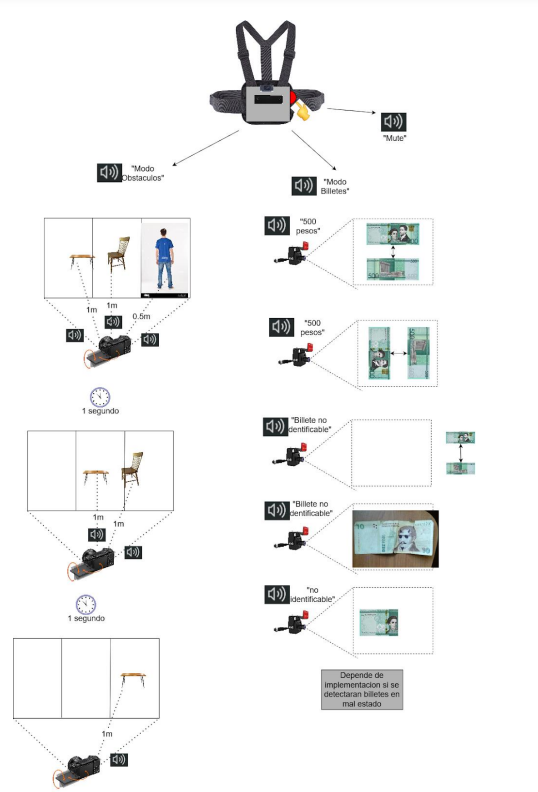

En la figura superior se encuentra diagramado el flujo de operaciones que ejecuta el sistema cada ciclo. Algunos puntos que valen la pena destacar son los siguientes: es posible el cambio de modo de funcionamiento o el apagado del sistema de manera asíncrona. No es necesario esperar que algún audio se termine de reproducir para empezar a procesar la próxima imagen, ya que esta tarea es ejecutada en hilos distintos.

El usuario interactúa con el dispositivo mediante un solo botón físico y unos auriculares que se conectan automáticamente por bluetooth (si ya se habían conectado manualmente previamente) o se podrían conectar mediante la salida de audio de la Raspberry Pi. El botón se utiliza para encender el dispositivo (si el dispositivo esta apagado), cambiar de modo de funcionamiento y para apagar el dispositivo si se deja presionado por tres o más segundos. Toda la retroalimentación se le brinda al usuario de manera auditiva.

En las pruebas de detección de billetes determinamos que el rendimiento bajo las mejores condiciones resulta en un tiempo promedio de respuesta de 4 segundos. Esta cantidad acomoda el tiempo que le toma al usuario posicionar el billete frente al sensor y el tiempo que podría tomarle al sensor enfocar la imagen al objetivo. A medida que empeora la iluminación del ambiente el rendimiento se torna inconsistente y el tiempo promedio de respuesta aumenta.

En las pruebas de distancia descubrimos que el sensor logra detectar y estimar con un margen de error de +-0.1m la distancia de objetos que se encuentran entre 0 y 15 metros de distancia del sensor. En la prueba de multitud obtuvimos un resultado inesperado, donde el rendimiento fue mejor en el ambiente de alta iluminación que en el de iluminación regular.

Conclusiones

Este proyecto ha demostrado ser eficaz en la implementación de soluciones de visión computacional para las tareas descritas en los objetivos del proyecto. La funcionalidad de detección de billetes funciona consistentemente y en tiempo real bajo condiciones ideales de iluminación, permitiendo a los usuarios identificar la denominación de los billetes dominicanos sin asistencia. La detección de obstáculos amplía el rango de detección de un invidente hasta 14 metros más allá de las dimensiones de su bastón, mejorando su percepción del entorno. El dispositivo es fácil de usar, tiene una curva de aprendizaje mínima y componentes pequeños que permiten su portabilidad.

Un resultado inesperado fue la mayor consistencia en la detección de billetes cuando están orientados por el anverso en lugar del reverso. Esto puede deberse a que los diseños de los billetes anversos contienen más elementos gráficos, facilitando la detección. En condiciones de iluminación inadecuadas, el desempeño del dispositivo disminuye, y la detección de obstáculos se ve afectada cuando los objetos se solapan. Además, el dispositivo no puede determinar la legitimidad de los billetes, y el estado físico de los billetes también afecta la precisión de la detección.

Recomendaciones

Para futuras mejoras del proyecto, se sugiere agregar una linterna para mejorar la detección de billetes en condiciones de poca iluminación y considerar la integración de un sensor IR o un sensor binocular con IR para mejorar la detección de obstáculos en baja iluminación. Incluir comandos por voz y rediseñar el sistema de retroalimentación para el módulo de detección de obstáculos también serían beneficiosos. Además, sería útil mejorar la distribución de calor de los componentes o agregar métodos de refrigeración, así como idear y desarrollar más modos de funcionalidad para el dispositivo.

Referencias

- Rosenblum, See What I’m Saying: The Extraordinary Powers of Our Five Senses. Los Angeles, 2010.

- A. Semary, S. M. Fadl, M. S. Essa, and A. F. Gad, “Currency recognition system for visually impaired: Egyptian banknote as a study case,” in 2015 5th International Conference on Information & Communication Technology and Accessibility (ICTA), 2015, pp. 1–6. doi: 10.1109/ICTA.2015.7426896.

- “Ciegos no detectan marcas para no videntes en billetes dominicanos,” Diario Libre, Santo Domingo, Apr. 23, 2014. Accessed: Jul. 23, 2022. [Online]. Available: https://www.diariolibre.com/actualidad/ciegos-no-detectan-marcas-para-novidentes-en-billetes-dominicanos-JKDL577781

- Zhang, W. Yan, and M. Kankanhalli, “Overview of currency recognition using deep learning,” Journal of Banking and Financial Technology, vol. 3, Jan. 2019, doi: 10.1007/s42786-018-00007-1.

- Katzschmann, B. Araki, and D. Rus, “Safe Local Navigation for Visually Impaired Users With a Time-of-Flight and Haptic Feedback Device,” IEEE Transactions on Neural Systems and Rehabilitation Engineering, vol. PP, p. 1, Jan. 2018, doi: 10.1109/TNSRE.2018.2800665.

- Katzschmann, B. Araki, and D. Rus, “Safe Local Navigation for Visually Impaired Users With a Time-of-Flight and Haptic Feedback Device,” IEEE Transactions on Neural Systems and Rehabilitation Engineering, vol. PP, p. 1, Jan. 2018, doi: 10.1109/TNSRE.2018.2800665.